Dans quelques semaines, on fêtera le premier anniversaire de ChatGPT. Depuis la mise en production de cette IA générative, la littérature sur le sujet est pléthorique. Le robot conversationnel d’OpenAI a connu un indéniable succès qui ne s’est pas tari depuis son apparition. Ses performances, ont été perçues comme une avancée majeure dans le domaine de l’intelligence artificielle que des augures estiment destinée un jour à remplacer, sinon dépasser, l’être humain. On ne peut nier la fascination qu’a exercé – et continue à exercer – cette IA sur celleux qui ont testé l’outil. Depuis, beaucoup de chercheur.e.s nous met opportunément en garde contre une IA devenue si puissante que nous abdiquerions petit à petit, dans le désordre, notre esprit critique, nos libertés individuelles et nos savoir-faire.

Cependant, ne prêtons-nous pas à cette IA un pouvoir excessif, alimenté par notre fort pouvoir imaginaire en la matière ? On porte tous en nous quelque chose de Skynet et de HAL-9000. En réalité, de nombreuses personnes pointent du doigt que ce pouvoir excessif que nous lui accordons se heurte à une réalité bien plus contraigante qu’on imagine. Comme l’explique, à plusieurs reprises, Laurence Devillers, chercheur en éthique de l’IA, avant d’utiliser ChatGPT ou un autre modèle de langage, il faut en comprendre son fonctionnement mais surtout les enjeux.

Aujourd’hui, on réfléchit sérieusement à l’encadrer et à la réguler. Et paradoxalement, le premier coup de salve vient des Etats-Unis et plus spécifiquement de la Maison-Blanche. Cette semaine, le président Joe Biden a émis un décret intitulé : President Biden Issues Executive Order on Safe, Secure, and Trustworthy Artificial Intelligence. C’est à l’heure actuelle le plus vaste ensemble des règles et de lignes directrices signées par le président américain. Il exigera plus de transparence de la part des entreprises de l’IA sur le fonctonnement de leurs modèles et établira une série de nouvelles normes;notamment sur la labelisation des contenus générés par l’IA. Pourquoi paradoxalement ? C’est quasiment la même administration qui, sous Barack Obama, avait publié la feuille de route donnant le La de ce que représenterait l’intelligence artificielle pour le pays.

publish/post/138478633

Que devenons-nous retenir de ce décret ?

Le décret de la Maison Blanche demande au ministère du commerce d’élaborer des lignes directrices pour labeliser les contenus générés par l’IA. Les entreprises spécialisées dans l’IA utiliseront ces orientations pour développer ces outils que la Maison-Blanche espère voir adoptés par les agences fédérales.

L’espoir est que l’étiquetage de l’origine des contenus textuels, audio et visuels nous permettra de savoir plus facilement ce qui a été créé en ligne à l’aide de l’IA. Ce type d’outils est largement proposé comme solution aux problèmes liés à l’IA tels que les « deepfakes » et la désinformation.

Le problème, c’est que les technologies telles que les filigranes sont encore balbutiantes. Il n’existe actuellement aucun moyen totalement fiable d’étiqueter un texte ou de déterminer si un contenu a été généré par une machine. Les outils de détection de l’IA sont encore faciles à tromper.

Le décret n’oblige pas non plus les acteurs de l’industrie ou les agences gouvernementales à utiliser ces technologies.

Le décret demande aussi au NIST (National Institute of Standards and Technology) d’établir une série de tests afin de casser les modèles et en révéler ainsi les vulnérabilités (notamment les biais racistes et sexistes). Mais là encore, il n’y a pas de contraintes imposées, les entreprises du secteur sont libres d’utiliser ou pas ces tests.

Cependant, côté UE, nous ne sommes pas en reste. La Commission et les Etats membres ont convenu, dès 2021, d’une série de mesures qui visent “à renforcer la recherche et les capacités industrielles tout en garantissant la sécurité et les droits fondamentaux.”

Bref, vous conviendrez avec moi que tout ceci n’est pas à la hauteur des enjeux. Ni le décret présidentiel, ni le “en même temps européen” réfléchissent sérieusesment aux murs auxquels va se heurter le développement de l’IA. J’en vois personnellement 3 : ceux de la confiance, de la sécurité et de l’énergie.

Attardons-nous un petit moment sur celui de l’énergie.

Il est tout même assez incroyable que nous ne réfléchissions pas déjà au mur de l’énergie. 5En Europe, 50 ans après le premier choc pétrolier, la guerre en Ukraine nous a tout juste fait prendre conscience de notre dépendance énergétique. Si l’idée sous-jacente est de construires plus d’éoliennes, de parcs de panneaux solaires et des centrales nucléraires pour couvrir développer et couvrir les LLMs, on se fracassera avec violence contre ce mur-ci (et je ne pose pas même les questions de domination et d’exploitation que cela implique).

Pourtant, on ne peut nier que nous ne sommes pas mis au coutant. Chaque année, l’es chercheur.e.s de l’université de Stanford publie un AI index et celui de 2023 nous alerte (encore) sur l’impact environnemental de l’IA. “BLOOM’s training run emitted 25 times more carbon than a single air traveler on a one-way trip from New York to San Francisco.” (BLOOM est l’équivalent français de ChatGPT)

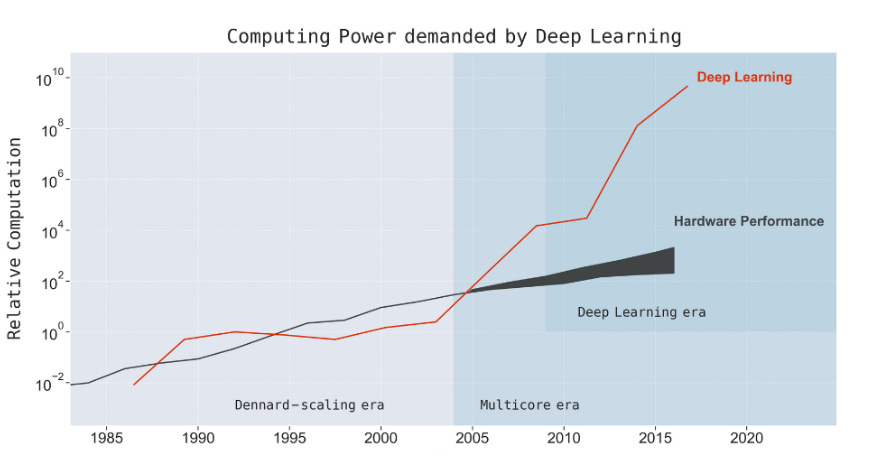

Lédition de 2019 présentait déjà pour la première fois l’évolution des besoins de calcul des applications de l’IA qui ont suivi la loi de Moore (doublement tous les 18 mois) de 1960 à 2012. Depuis, ces besoins doublent tous les trois mois et demi ! Cet article fondateur d’Emma Strubell établissait que l’entraînement d’un grand réseau de neurones tout en optimisant l’architecture du réseau, consommait autant d’énergie que cinq voitures particulières pendant toute leur durée de vie.

Et depuis, cette tendance a été confirmée par d’autres études dont celle de Neil Thompson qui concluait son rapport en écrivant : “les limites de calcul de l’apprentissage profond seront bientôt contraignantes pour toute une série d’applications, ce qui rendra impossible l’atteinte d’importantes étapes de référence si les trajectoires actuelles se maintiennent.” Ce graphique, extrait du même rapport, est suffisamment éloquent :

Et là on ne parle que de consommation électrique.

Mais qu’en estil de l’eau ? La réponse est donnée dans cet article de Géo. Lorsque vous posez une cinquantaine de questions à ChatGPT, vous videz une petite bouteille d’eau.

Alors certain.e.s vous diront que tous les acteurs du secteur cherchent à améliorer les LLMs et les architectures pour réduire considérablement leur impact environnemental. Sauf que nous sommes face à un problème de taille : le manque de temps. On peut imaginer mille et une solutions mais ce mur de l’énergie, couplé avec celui de l’eau, provoquera à très court terme un troisième hiver de l’IA. Devons-nous le souhaiter ? Oui.